Hedef: Farkındalık yaratmak ve “Local LLM” kavramını tanıtmak.

Son birkaç yıldır toplantı odalarından üretim bantlarına kadar herkesin gündeminde aynı konu var: Yapay Zeka. Muhtemelen siz de e-postalarınızı düzenlerken veya bir raporu özetlerken ChatGPT veya benzeri araçlardan yardım alıyorsunuz.

İşler hızlandı, verimlilik arttı. Peki ama hiç durup şunu düşündünüz mü: “Benim bu yapay zekaya yazdığım şirket verileri aslında nereye gidiyor?”

Bir KOBİ veya kurumsal firma için “verimlilik” ne kadar önemliyse, “veri egemenliği” de o kadar hayati olmalıdır. Bugün, bulut tabanlı modeller ile kendi sunucularınızda çalışan Local LLM (Yerel Yapay Zeka) çözümleri arasındaki farkı teknik jargona boğulmadan inceleyeceğiz.

Veriniz Şirketin Kapısından Çıkıyor Mu? Local LLM ile Güvenlik

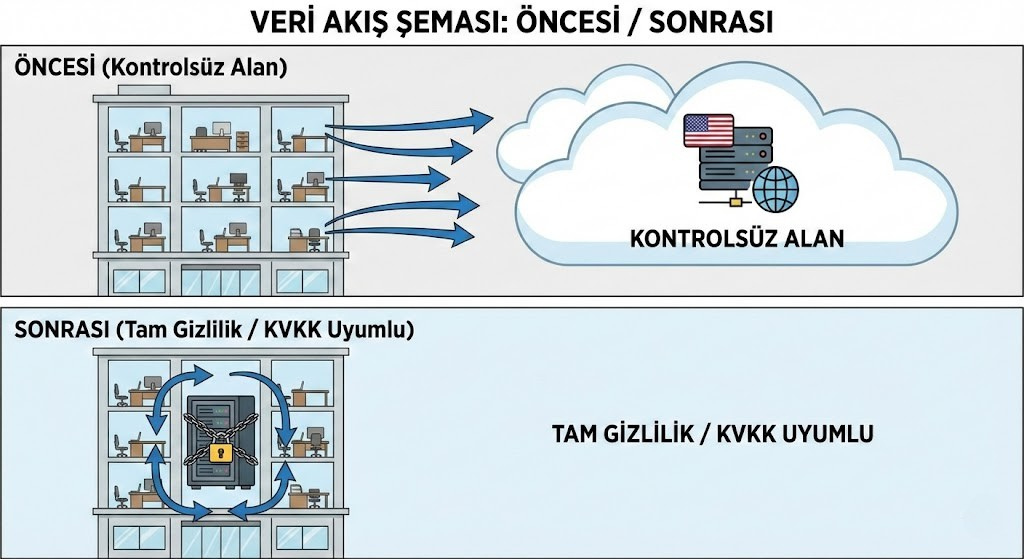

Bulut tabanlı (Cloud) yapay zeka modellerini (ChatGPT, Claude, Gemini vb.) kullandığınızda, verileriniz işlenmek üzere yurt dışındaki sunuculara gönderilir. Bu, kişisel kullanımda sorun olmayabilir. Ancak müşteri sözleşmeleri, finansal tablolar veya AR-GE verileri söz konusu olduğunda durum değişir.

KVKK ve GDPR gibi regülasyonlar, verinin nerede işlendiğini önemser. Local LLM kurduğunuzda ise yapay zeka, internete ihtiyaç duymadan, tamamen sizin ofisinizdeki veya özel bulutunuzdaki sunucuda çalışır.

Neden Herkes “Local LLM” Çözümlerine Dönüyor?

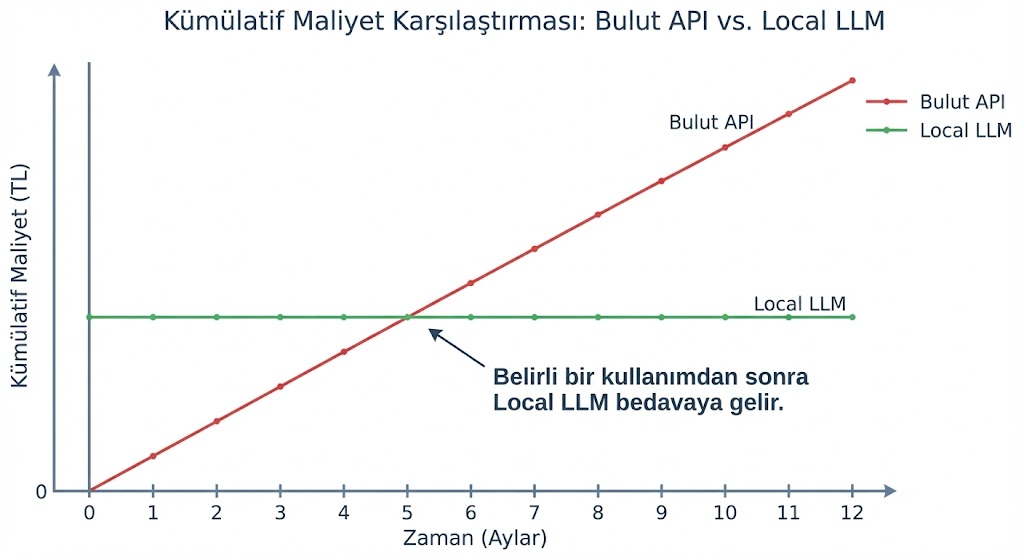

Sadece gizlilik değil, maliyet ve performans da ibreyi Local LLM ve yerel çözümlere çeviriyor.

- Sabit Maliyet Avantajı: Bulut sistemlerinde kullandıkça ödersiniz (Pay-as-you-go). Sorgu sayısı arttıkça faturanız kabarır. Yerel sistemlerde ise donanımı bir kez kurarsınız; maliyetiniz sabit kalır.

- Hız ve Latency (Gecikme): Verinin okyanus ötesine gidip gelmesini beklemezsiniz. Cevaplar milisaniyeler içinde ekranınızdadır.

- Özelleştirilebilirlik: Genel modeller “her şeyi biraz bilir”. Yerel modelleri ise sadece kendi şirket belgelerinizle eğitebilirsiniz.

Peki, Bu Sistemler Nasıl Çalışıyor?

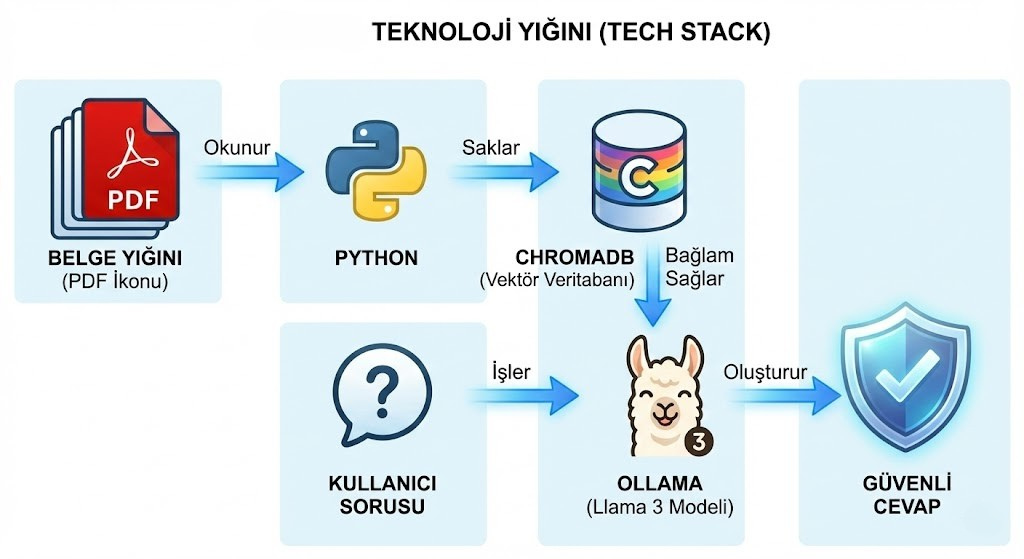

“Kendi yapay zekamızı kurmak” kulağa milyon dolarlık bir yatırım gibi gelebilir. Ancak bugün, açık kaynak (open source) teknolojiler sayesinde bu güç demokratikleşti. Meta (Llama 3), Mistral veya Google (Gemma) gibi devler, modellerini paylaşıyor. Biz mühendisler de bu modelleri alıp, RAG (Retrieval-Augmented Generation) dediğimiz mimari ile şirket hafızanıza bağlıyoruz.

Süreç özetle şöyle işliyor:

- Şirketinizin PDF, Word, Excel dosyalarını güvenli bir veritabanına (Örn: ChromaDB) aktarıyoruz.

- Açık kaynaklı bir modeli (Örn: Ollama üzerinden) bu veritabanına bağlıyoruz.

- Siz soru sorduğunuzda, yapay zeka cevabı internetten değil, sizin belgelerinizden bulup getiriyor.

Sonuç: Kontrolü Alın ve Kendi “Yapay Zeka Beyninizi” İnşa Edin

Yapay zeka bir trend değil, yeni bir iş yapış biçimi. Ancak bu gücü kullanırken şirketinizin mahremiyetinden ödün vermek zorunda değilsiniz.

Bu blogda ve Private AI çalışmalarımda temel amacım; Türk şirketlerinin verilerini yurt dışına çıkarmadan kendi Local LLM sistemlerini kurmalarına rehberlik etmektir.

Bu vizyonu sadece teorik yazılarla sınırlı tutmuyor, Türk-Alman Üniversitesi Sürekli Eğitim Merkezi (TAÜ-SEM) bünyesinde açtığımız eğitim programıyla pratiğe döküyoruz.

Eğer siz de “Verimiz bizim kalemizdir” diyorsanız ve bu sistemleri kendi sunucunuzda nasıl kuracağınızı akademik bir titizlikle öğrenmek istiyorsanız, sizi “Private AI & RAG Engineering” programımıza davet ediyorum.

Eğer siz de “Verimiz bizim kalemizdir” diyorsanız, 24 Ocak 2026’da başlayacak uygulamalı programa davetlisiniz. Python, Ollama ve Docker kullanarak şunları inşa edeceğiz:

- Data Alchemist: Şirketinizdeki PDF yığınlarını işlenebilir veriye dönüştüren motor.

- Corporate Brain: Şirket hafızasıyla konuşan, %100 yerel arama asistanı.

- Compliance Auditor: Kuralları öğrenen ve otomatik denetim yapan YZ ajanı.

Bulut yok. API ücreti yok. Tamamen Local.

Kontenjanımız sınırlıdır. Detaylı bilgi almak ve kaydolmak için aşağıdaki bağlantıyı kullanabilirsiniz.

👉 TAÜ-SEM Eğitim Detayları ve Kayıt: Private AI & RAG Engineering: Veri Gizliliği Odaklı Kurumsal YZ Ajanları Geliştirme Programı

Geleceğin iş dünyasında rekabet avantajı, sadece yapay zekayı kullananların değil; onu güvenli, özelleştirilebilir ve Local LLM mimarileriyle kendi verisi üzerinde eğitenlerin elinde olacaktır. Şimdi harekete geçme zamanı.

Projelerinizde profesyonel desteğe ihtiyaç duyarsanız İletişim sayfasından bana ulaşabilirsiniz.